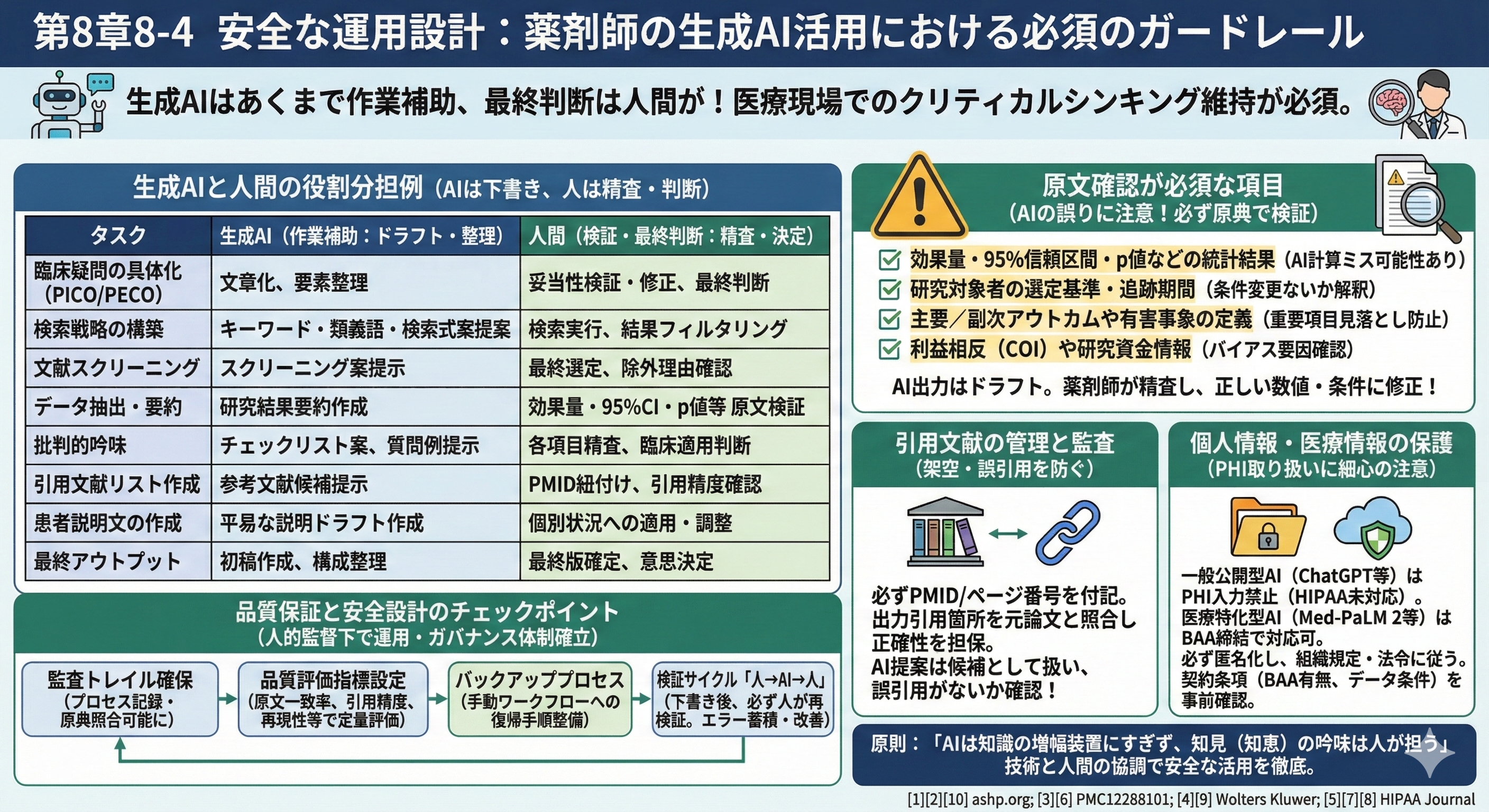

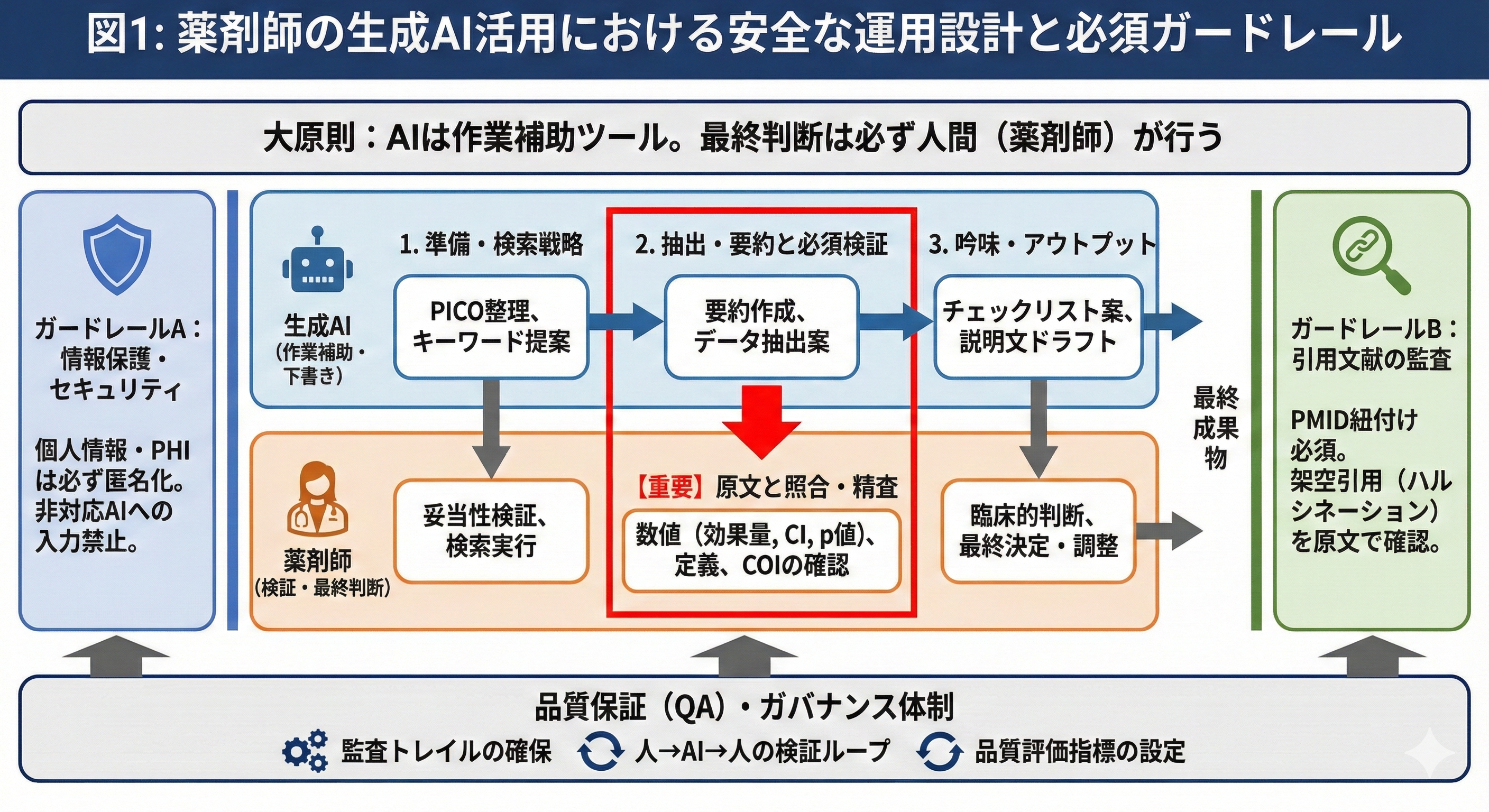

生成AIはあくまで作業補助ツールであり、薬剤師の判断を置き換えるものではありません[1][2]。AI出力はドラフト作成や要素整理に役立つものの、最終判断は必ず人間が行います。特に医療現場ではAIの潜在的な誤り(偽情報・偏り)に注意し、ヒトのクリティカルシンキングを維持することが強調されています[1][3]。

生成AIと人間の役割分担例

Wolters Kluwerも指摘するように、生成AI活用には明確な使用ポリシーと役割分担が不可欠です[4]。以下は薬剤師業務における生成AI支援と人間による検証・判断の分担例です。生成AIは下書き作成やデータ整理、検索支援などを担当し、薬剤師は原典確認や精査、最終的な意思決定を担います。

| タスク | 生成AI(作業補助) | 人間(検証・最終判断) |

|---|---|---|

| 臨床疑問の具体化(PICO/PECO) | 文章化や要素の整理 | 妥当性検証・修正、最終判断 |

| 検索戦略の構築 | 検索キーワード・類義語の提案、検索式案 | 検索実行・結果のフィルタリング |

| 文献スクリーニング | スクリーニング案提示(曖昧さ低減支援) | 最終的な選定・除外理由の確認 |

| データ抽出・要約 | 研究結果の要約作成 | 効果量・95%CI・p値などの原文検証 |

| 批判的吟味 | チェックリスト案や質問例の提示 | 各項目の精査・臨床的適用の判断 |

| 引用文献リスト作成 | 参考文献候補の提示 | PMID紐付け、引用精度の確認 |

| 患者説明文の作成 | 平易な説明のドラフト作成 | 個別状況への適用・調整 |

| 最終アウトプット | 初稿の作成・構成整理 | 最終版確定・意思決定 |

原文確認が必須な項目

生成AIが出力する要約や分析結果は誤りを含む可能性があるため、人が必ず原典で検証する必要があります[5]。特に以下の項目は必須チェックポイントです:

- 効果量・95%信頼区間・p値などの統計結果(AIは計算を誤ることもある)

- 研究対象者の選定基準・追跡期間(対象条件を変えず解釈できているか)

- 主要/副次アウトカムや有害事象の定義(重要アウトカムを取りこぼしていないか)

- 利益相反(COI)や研究資金情報(論文のバイアス要因)

これらはAIでは判断しきれず、必ず原文で一致を確認します。AI出力はあくまで「ドラフト」なので、薬剤師が内容を精査し、必要に応じて正しい数値や条件に修正してください。

引用文献の管理と監査

生成AIによる文献要約には架空の引用や誤引用が含まれることが報告されています[6]。例えば、AIは存在しない論文を「参考文献」に挙げる誤りを起こすことがあります[6]。したがって、引用文献には必ずPMIDや該当ページ番号を付記し、出力された引用箇所を元論文と照合して正確性を担保します。AIが提案した参考文献は候補として扱い、該当箇所が原文と一致しているか、誤引用がないかを必ず確認してください。

個人情報・医療情報の保護

生成AI活用では個人情報や医療情報の取り扱いにも細心の注意が必要です。OpenAIのChatGPTなど一般公開型ツールはHIPAA(米国医療情報保護法)に対応しておらず、PHI(個人医療情報)の入力に使用できません[7]。一方で、GoogleのMed-PaLM 2など医療特化型AIツールはBAA締結の下でHIPAA対応が可能です[8]。したがって、患者データや機密情報は必ず匿名化の上、組織規程や法令に従って扱うこと。利用するクラウドAIサービスの契約条項(BAA締結の有無、データ取り扱い条件)を事前に確認し、PHI入力禁止などのルールを定めてください。

品質保証と安全設計のチェックポイント

AIツールは常に人的監督下で運用されるべきです[1]。また、Wolters Kluwerが指摘するように、AI導入には明確なガバナンス体制とポリシーが不可欠であり[9]、組織内にAI運用委員会を設置してルールや責任範囲を定めることが推奨されています[10][9]。具体的には以下のような仕組みを組み込みます:

- 監査トレイルの確保: AIによる要約や判断プロセスを記録し、必要に応じていつでも原典と照合できるようにする。

- 品質評価指標の設定: 要約の原文一致率や引用のPMID一致率、検索結果の再現性、時間短縮効果、見落とし率などの指標でAI支援前後の品質を定量評価する。

- バックアッププロセス: AIが利用できない場合や誤作動時に備え、従来のワークフロー(手動検索・レビュー)に戻れる手順を整備する。

- 検証サイクル(人→AI→人): EBM_Pharmacist_MVPなどのフレームワークでも採用しているように、AIによる下書き後に必ず人が再検証する「人→AI→人」のループを組み込む。エラー事例を蓄積し、プロンプトや運用ルールを継続的に改善します。

これらのガードレールを設定することで、生成AIは薬剤師業務を効率化しつつ、品質と安全性を確保できます。重要なのは「AIは知識の増幅装置にすぎず、知見(知恵)の吟味は人が担う」という原則です[3]。技術と人間の協調を念頭に、安全なAI活用を徹底してください。

これらのガードレールを設定することで、生成AIは薬剤師業務を効率化しつつ、品質と安全性を確保できます。重要なのは「AIは知識の増幅装置にすぎず、知見(知恵)の吟味は人が担う」という原則です[3]。技術と人間の協調を念頭に、安全なAI活用を徹底してください。

参考文献

- [1] [2] [10] ashp.org https://www.ashp.org/-/media/assets/policy-guidelines/docs/statements/artificial-intelligence-in-pharmacy.pdf

- [3] [6] Exploring the Dilemma of AI Use in Medical Research and Knowledge Synthesis: A Perspective on Deep Research Tools - PMC https://pmc.ncbi.nlm.nih.gov/articles/PMC12288101/

- [4] [9] GenAI in healthcare brings the need for risk policies | Wolters Kluwer https://www.wolterskluwer.com/en/expert-insights/genai-in-healthcare-brings-the-need-for-risk-policies

- [5] [7] [8] Is ChatGPT HIPAA Compliant? Updated for 2025 https://www.hipaajournal.com/is-chatgpt-hipaa-compliant/