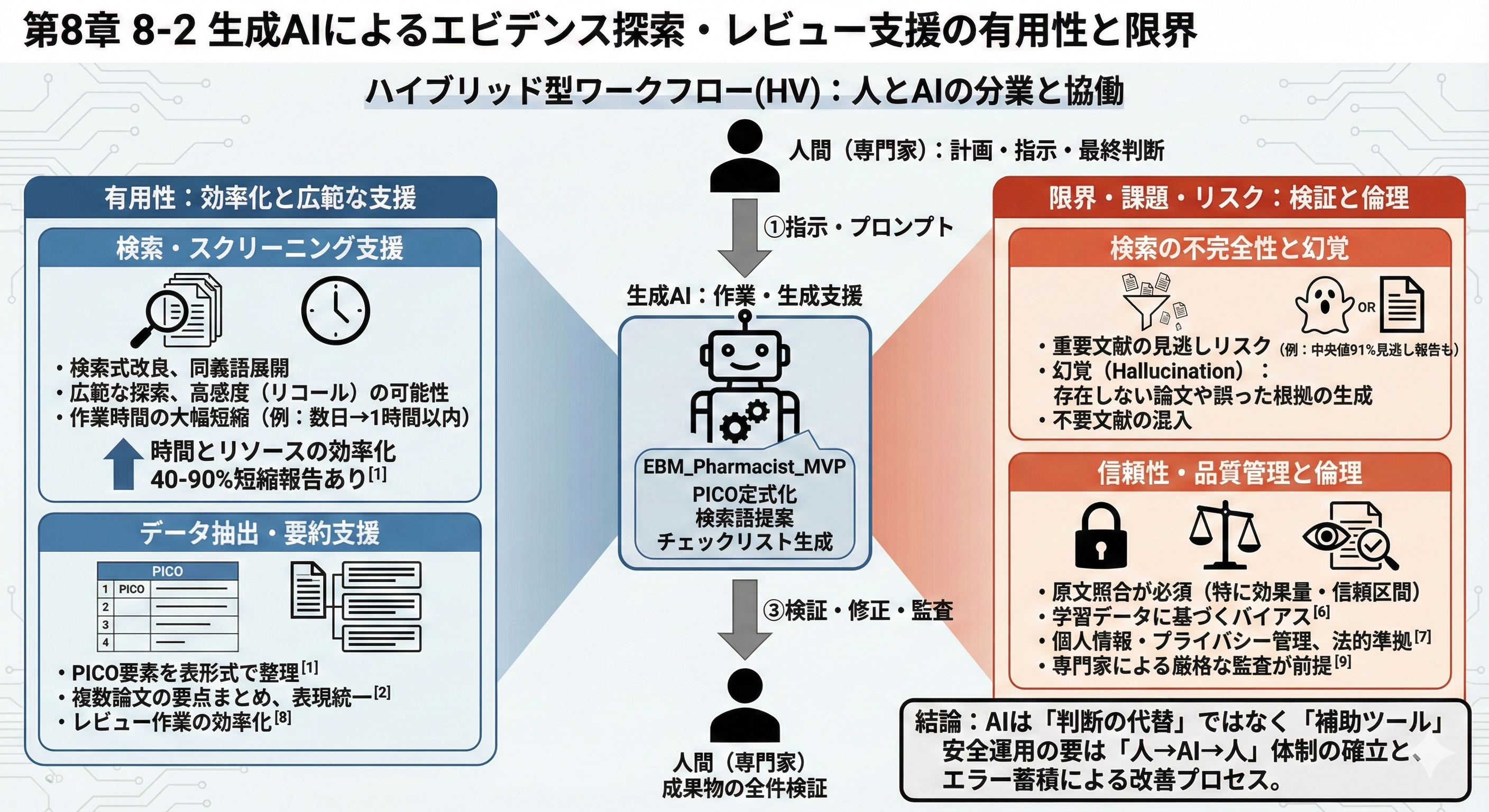

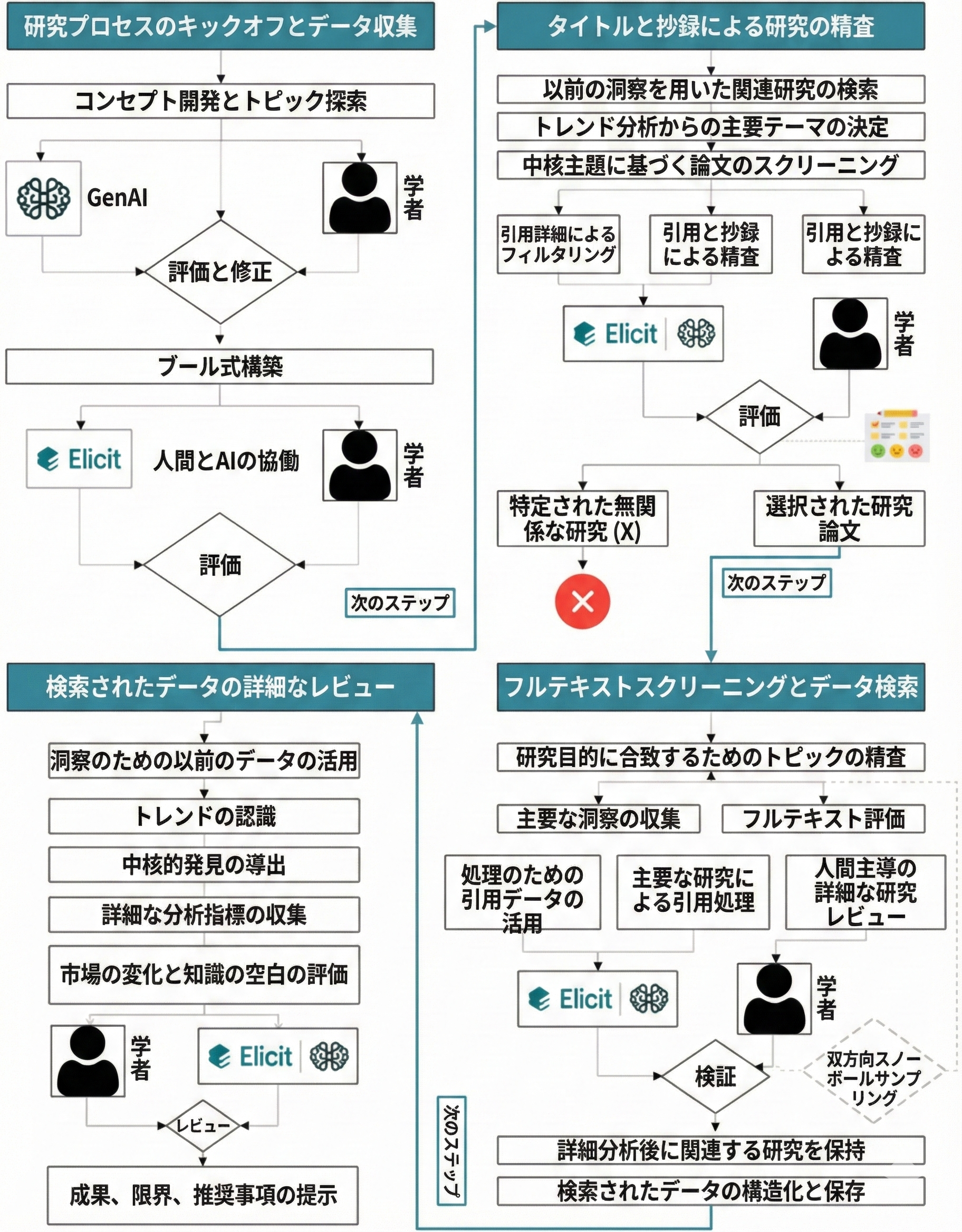

生成AIを用いたエビデンスレビューでは、人間の専門家とAIが分業して進めるハイブリッド型ワークフローが重要です。近年、検索クエリの自動生成やレコードの自動スクリーニング、文献要約など、システマティックレビュー工程の各段階で生成AIが支援する事例が報告されています[1][2]。例えば、AIは大量の文献から関連研究を抽出する際に検索語の展開や絞り込みを行い、作業時間を大幅に短縮することが期待されており、ある報告では人手では数日かかるタイトル・要旨スクリーニングをAIが1時間以内に終えた例が示されています[3]。筆者らが開発したAIエージェント「EBM_Pharmacist_MVP」も、PICO形式への疑問定式化や検索語提案、Appraise用のチェックリスト自動生成などを担い、実際の薬剤師EBM実践における生成AI活用の一例となっています。

検索・スクリーニング支援: 生成AIは検索式の改良候補や同義語展開を提案し、広範な文献探索を支援します[1]。適切なプロンプト設計を行えば、高い感度(リコール)で関連文献を見つけることが可能です[4][3]。一方、AIのみでは重要な文献を見逃したり、不要な文献を含めてしまうリスクもあります。実際、あるレビューではAI検索で関連研究の中央値91%を見逃したとの報告もあります[1]。

データ抽出・要約支援: AIは抽出すべきPICO要素を表形式で整理したり、複数の論文から要点を簡潔にまとめる作業を補助します[1][2]。レビュー作業の効率化や表現統一の支援には有用ですが、AIが生成した要約内容や引用箇所は必ず原文と照合する必要があります。AIは「もっともらしい」文章を作る一方で、存在しない論文や誤った根拠を示す(いわゆる幻覚)がちであるためです[5][6]。

信頼性と品質管理: 医療分野では特に引用の正確性やデータの透明性が重視されるため、AIのアウトプットには厳格な品質管理が求められます[7][6]。例えば効果量や信頼区間などはAIの生成結果だけで確定せず、必ず原文を確認します。また、AIツールを用いたレビューでは専門家による監査が前提とされ、「AIによる下書きを人間が検証する」流れが不可欠です[7][2]。

活用時の課題と倫理的懸念

生成AIの活用には多くの可能性がある一方で、精度や倫理、安全性に関する懸念もあります。研究レビュー向けの調査では、AIは高速かつ広範なサーチ支援に優れる反面、誤引用や根拠追跡の難しさが指摘されています[1][5]。具体的には、ある事例でAIが存在しないRCTを「架空の根拠」として要約に挙げてしまった例が報告されており、AIの提示する情報がいつでも検証可能とは限りません[5]。また、機械学習モデルには訓練データに基づくバイアスが内在するため、従来見落とされがちだった偏りに気づけないリスクもあります[6][8]。さらに、個人情報・医療情報を扱う場面では、入力データの匿名化やプライバシー管理、利用規約遵守など細心の運用設計が求められます。

時間とリソースの効率化: 生成AIは大量データの処理を自動化し、医療者の負担軽減に貢献します。複数の研究で40~90%の時間短縮効果が報告されており[3][9]、日常業務での利用価値が期待されています。

エラーと幻覚: 一方、AIは時に「もっともらしい誤情報(幻覚)」を生成し、引用が実際の論文に基づかないケースがあります[5][6]。引用整合性を確保するには、原典のPMIDや該当箇所を明示してAI生成内容と紐付けるなど、厳重な監査体制が必要です。

倫理・安全: 医療現場でのAI活用には品質保証と倫理配慮が必須です。患者安全を守る観点から、AIによる推奨や要約はあくまで支援情報にとどめ、最終判断は人間が行う姿勢が重要です[8][6]。また、医療データの機密性や医療機器規制への準拠など、法的・契約的な要件も整備する必要があります。

生成AIはエビデンス探索・レビューの作業を強力に補助しますが、「判断の代替」とせず、あくまで下書き・整理の補助ツールとして位置づけるのが現実的です[7]。特に薬剤師が活用する際は、生成AIを利用したワークフローの「成果物すべてを人間が再検証する(人→AI→人)」体制を確立し、エラー事例を蓄積しながらプロンプトや運用ルールを改善していくことが安全運用の要となります[7][2]。このように、有用性と限界を明確に把握した上でAI支援を設計すれば、薬剤師によるEBM実践の効率と質を高める一助となるでしょう。

参考文献

-

[1] [7] [8] Generative artificial intelligence use in evidence synthesis: A systematic review - PMC https://pmc.ncbi.nlm.nih.gov/articles/PMC12527500/

-

[2] [3] [4] [5] [6] [9] Can generative AI reliably synthesise literature? exploring hallucination issues in ChatGPT | AI & SOCIETY https://link.springer.com/article/10.1007/s00146-025-02406-7